Como o big data difere dos dados normais?

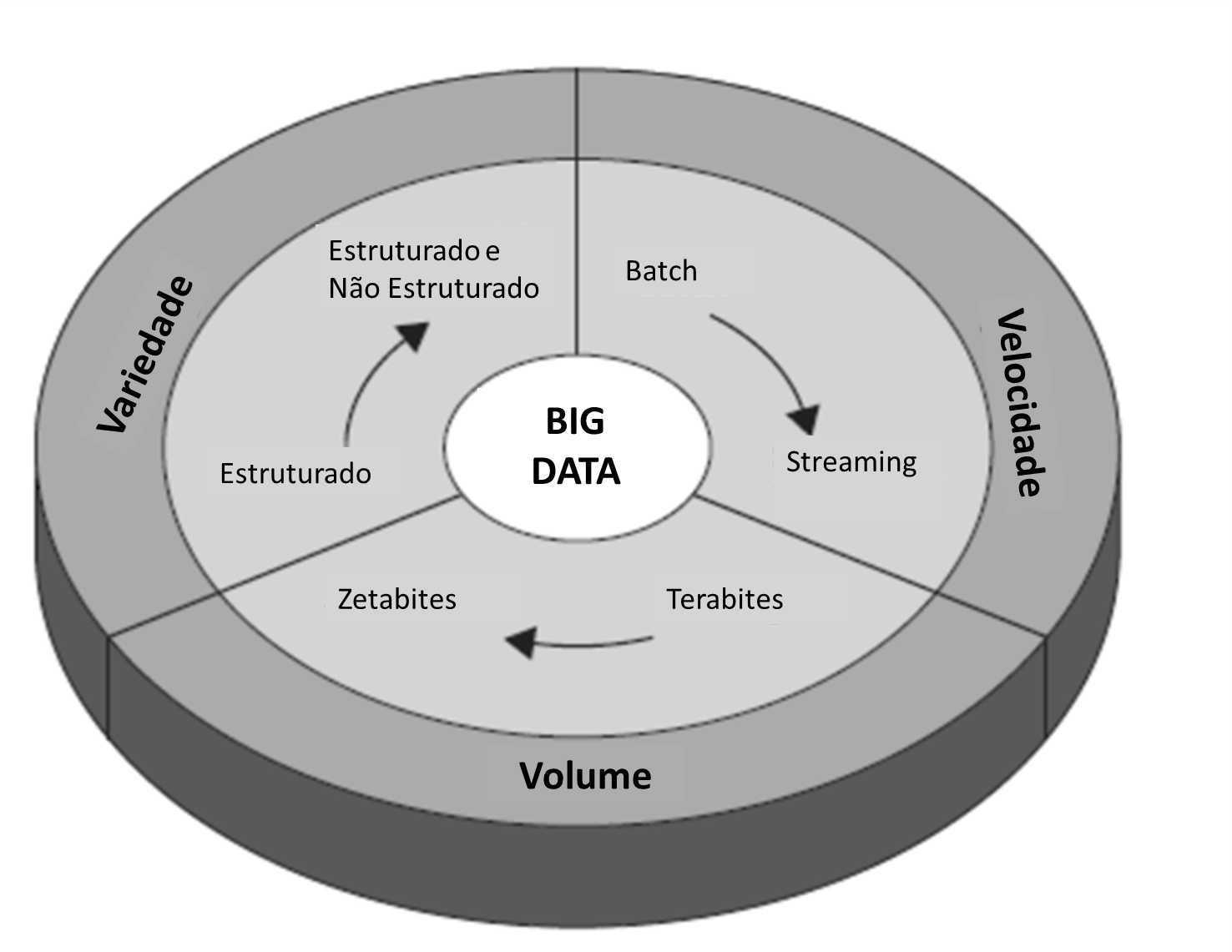

Big Data tem como principal objetivo a tomada de decisão em tempo real baseada em análise de dados. É direcionado para o tratamento de grandes volumes de informação, com grande variedade de dispositivos e velocidades de informação.

A quantidade de informações que temos hoje é muito maior e não é capaz de ser processada pelos métodos tradicionais. Bancos de dados relacionais são demasiado caros e restritivos para tratar essa nova demanda. Os modelos não-relacionais mais escaláveis e flexíveis estão vindo à tona.

Existem alguns termos usados para descrever dados.

- O primeiro é o volume, que é uma característica óbvia do nome big data. A quantidade de informação é o maior problema e levou os engenheiros a investir em sistemas distribuídos como a solução.

- Em seguida, é a velocidade, que se refere à taxa em que os novos dados são criados. A velocidade de dados do Facebook é muito superior do que de um site de uma empresa tradicional. Com tantas interações no Facebook todos os dias, o Facebook precisa fazer uma importante decisão: o que manter e o que jogar fora? Sites de compras online enfrentam um dilema semelhante. Cada vez que um usuário clica em um item ou escreve um termo de pesquisa, a empresa deve decidir se deseja salvar essa informação. No entanto, quanto maior o volume para salvar, maior velocidade é necessária para converter dados em insights. Se os varejistas são lentos para personalizar a experiência da web para seus clientes devido a um atraso no processamento de dados, os concorrentes mais rápidos são susceptíveis de ganhar.

- Por último, existe variedade. Se os dados provêm de várias fontes e em várias formas, apresenta um conjunto de questões a resolver muito mais complicado.

Veja algumas estatísticas dos desafios da comunicação em larga escala:

Volume de Informação …

- 10 aparelhos conectados por casa para 2020

- 5 aparelhos conectados por usuário para 2020

- 5 bilhões de usuários da internet em 2020

Variedade de dispositivos e formas …

- Smartphones e tablets

- M2M

- RFID

- NFC

- Aparelhos inteligentes 4G

- Vídeo chamada e vídeo em tempo real

- Wi-Fi

Velocidade para o tratamento de altos volumes de informação …

- Análise em tempo real

- Estratégia Preventiva

- Aproveitar novas oportunidades

Por ter essas características, quaisquer projetos envolvendo big data mexem com o núcleo de informação e decisão da empresa, têm alta conexão com serviços e projetos de datacenter, cloud computing, redes IP VPN, mobilidade e unified communication.

Big data e Handoop

Vamos supor que você tenha um grande volume de dados de variedade significativa. As chances de você poder gerar informação ou insights são poucas ou nenhuma, especialmente se não for identificado um padrão óbvio.

Uma palavra importante em big data é Hadoop, uma plataforma de software que permite às organizações executarem testes em seus dados com a esperança de responder perguntas.

A arquitetura distribuída é a chave por trás da capacidade de armazenar e processar grandes quantidades de informação.

Hadoop permite que as organizações gerem um sentido aos seus dados espalhando-os ao longo de um grupo de poderosos processadores que funcionam em paralelo para estudar as informações.

O método geral Hadoop usa o chamado Mapear Reduzir (MapReduce), que consiste em duas partes: mapear e reduzir.

- Suponha que você tem alguma pergunta que você deseja determinar a partir de seu conjunto de dados e seus projetistas escrevem uma função que teoricamente vai dar a resposta certa.

- A função Map vai separar a tarefa em várias partes e distribuí-la através de várias máquinas.

- Quando esta fase estiver completa, a função reduzir irá combinar os resultados em uma única tarefa para concluir a análise.

- Nenhuma máquina única é capaz de fazer uma grande quantidade de trabalho em tempo hábil, de modo que a estratégia de dividir e conquistar do Hadoop é uma ferramenta muito poderosa.